(一)人工智能定义

根据国家标准化管理委员会发布的《人工智能标准化白皮书(2018年)》,人工智能(Artificial Intelligence, AI)是指利用数字计算机或者由数字计算机控制的机器,模拟、延伸和扩展人类的智能,感知环境、获取知识并使用知识获得最佳结果的理论、方法、技术和应用系统。

人工智能是计算机科学的一个分支,被定义为能够模拟与人类大脑相关联的认知智能行为的“机器”,它是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。1956年由约翰.麦卡锡首次提出,当时的定义为“制造智能机器的科学与工程”。人工智能目的就是让机器能够像人一样思考,让机器拥有智能。时至今日,人工智能的内涵已经大大扩展,是一门交叉学科。

人工智能的功能维度从“计算→感知→认知→创造”层层递进。

√计算智能指对数据的基础逻辑计算和统计分析;

√感知智能指基于视觉、听觉的信号,对目标进行模式识别与分类;

√认知智能指实现对信息的认知、理解、推理和决策,并实现人、物、企业等智慧实体的认知与协同;

√智能创造指利用人工智能技术进行文学、艺术等方面的创造性创作以及工业领域的智能制造。它的出现不仅改变了传统的创作方式、思维方式和工业模式,也为拓宽人类的能力边界增添了新的可能性。

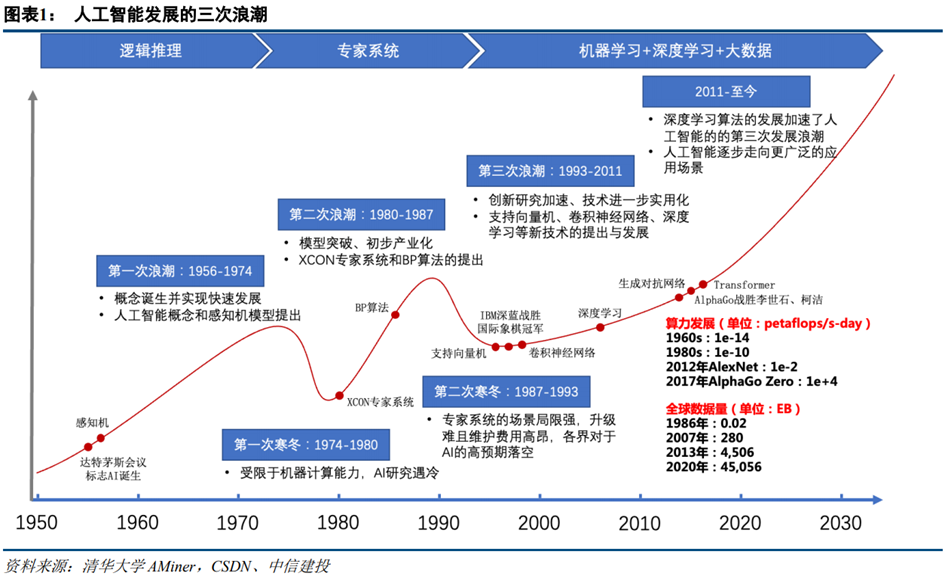

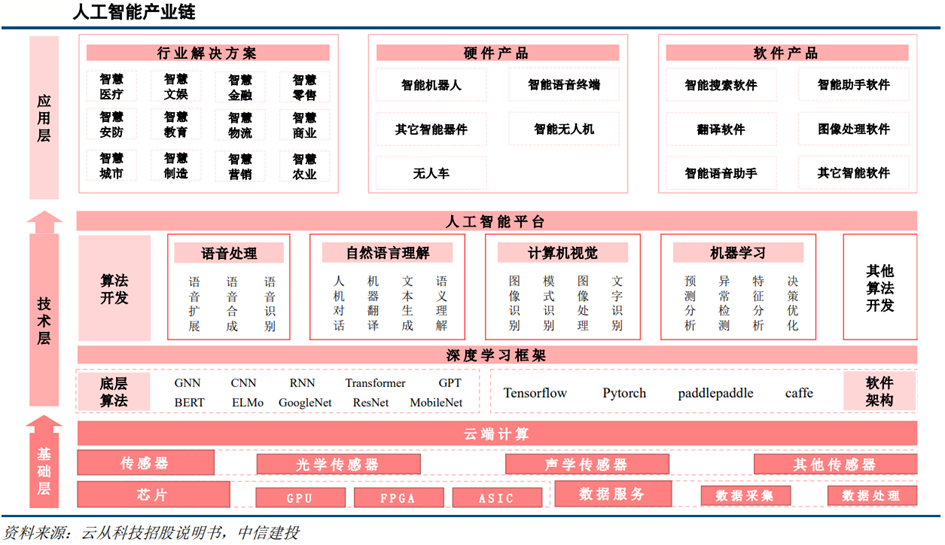

(二)人工智能分类 1.按能力分类 机器学习(Machine Learning):通过大量数据的学习和训练,让计算机能够自动提取数据中的规律和特征,并据此作出判断和预测。它是人工智能的重要基础之一。 深度学习(Deep Learning):是机器学习的一种高级形式,利用多层神经网络对数据进行处理和分析,实现更加复杂的任务,如图像识别、语音识别、自然语言处理等。 自然语言处理(Natural Language Processing , NLP):让计算机能够理解和处理人类自然语言,实现语音识别、语音合成、自动翻译等任务。 机器视觉(Computer Vision , CV):让计算机能够理解和处理图像和视频,实现图像识别、目标检测、人脸识别等任务。 决策式AI:指学习数据中的条件概率分布,根据已有数据进行分析、判断、预测,主要应用模型用于推荐系统和风控系统的辅助决策、用于自动驾驶和机器人的决策智能体。 生成式AI:即Generative Artificial Intelligence AIGC,指学习数据中的联合概率分布,并非简单分析已有数据而是学习归纳已有数据后进行演技创造,基于历史进行模仿式、缝合式创作,生成了全新的内容,也能解决判别问题。简单理解,生成式AI就是利用现有文本、音频文件或图像创建新内容的技术。比如,通过文字描述生成图像。人工智能在经历前期技术积累和迭代后,逐渐突破传统分析型AI领域,生成式AI正急速发展。 狭义人工智能 (ANI):Narrow AI,现有AI技术达到的状态,也称弱人工智能,此处的弱不是指能力,而是相对于人类智能。尽管可执行任务可能由高度复杂的算法和神经网络实现,依然是ANI,因为是单一目标驱动。 典型案例:人脸识别、搜索、自动驾驶。 通用人工智能 (AGI):可成功执行人类才能完成的智力型任务。与ANI一样,AGI 可以从经验中学习,发现和预测模式,但是 AGI 的智能水平更胜一筹。AGI 从先前数据或算法未解决的各种任务中推断出这些知识。 典型案例:Summit 超级计算机,全球为数不多的可以演示 AGI 的超级计算机之一。每秒可以执行 200 千万亿次计算,而人类完成这些计算需要十亿年。 超人工智能 (ASI):ASI 拥有完全自我意识。除了简单模仿、理解人类行为,还能从根本上掌握人类行为。 ASI 不仅具备人类特质,还拥有远胜于人类的处理能力和分析能力,ASI呈现了一个反乌托邦式的科幻未来,到那时人类将被逐渐淘汰出局。 (三)人工智能特征 根据人工智能的技术逻辑,人工智能有以下特征: (1)大数据为基底,算法为核心 人工智能是建立在数据之上的技术。人工智能发展的高度取决于数据为其提供的大量知识和丰富的经验,即通过在各个领域巨大的数据库中进行采集、加工、处理、分析和挖掘;在有丰富数据的基础上,通过人工智能算法,形成有价值的信息和知识模型,以此为人类提供服务。 (2)硬件为桥梁,人机合一 人工智能是智能化机器,是智能物体与人类智慧的融合。人工智能系统能够借助传感器等硬件对外界环境进行感知。具体而言,通过人的五种基本感觉,视、听、嗅、味、触接收各方信息,并以此通过文字、语音、表情输出必要的反应。借助人工智能作为现实与虚拟的接口,可实现人类与机器、人类与人类之间的共同协作。 (3)具备学习、推理能力,实现动态迭代 人工智能具有适应特性,能够随环境、数据或任务变化自动调节参数,优化模型。充分利用机器洞察人心的能力、人类对机器的驾驭能力,深入数字化连接,实现机器的自我迭代。 (4)三要素:数据、算力、算法 数据、算力、算法是人工智能三要素。人工智能模型的应用分为训练、推理两大环节。其中,数据与算力是模型训练的基础,算法是模型实现路径,近年人工智能的快速发展得益于三大要素的共同进步。 数据:人工智能“燃料”,全球数据量指数级增长。深度学习算法是推动人工智能技术突破性发展的关键技术理论,大量训练数据的训练支撑是深度学习算法的基础。训练数据越多、越完整、质量越高,模型推断的结论越可靠。根据Dimensional Research的全球调研报告,72%的受访者认为至少使用超过10万条训练数据进行模型训练,才能保证模型的有效性和可靠性。根据中国信通院数据,到2035年,全球数据量将达2142ZB,是2020年数据量的45-46倍。数据量的指数级增长有望为人工智能产业发展提供“燃料”。 算力:人工智能“底座”,AI芯片是核心。人工智能模型的训练依赖大量算力支持,海量算力是大规模训练及生产人工智能模型的前提。数据海量增加,算法模型愈加复杂,应用场景的深入和发展,带来了对算力需求的快速提升。根据《2022-2023中国人工智能计算力发展评估报告》,2021年中国智能算力规模达155.2每秒百亿亿次浮点运算(EFLOPS),2022年智能算力规模将达到268.0EFLOPS,预计到2026年智能算力规模将进入每秒十万亿亿次浮点计算(ZFLOPS)级别,达到1,271.4EFLOPS,2021-2026年期间年复合增长率达52.3%,而同期通用算力规模年复合增长率为18.5%。AI芯片专门用于处理人工智能相关的计算任务,其架构针对人工智能算法和应用进行专门优化,具有高效处理大量结构化和非结构化数据的特征。AI芯片类型包括GPU、NPU、ASIC、FPGA等,其中GPU是主要的人工智能加速芯片,根据《2022-2023中国人工智能计算力发展评估报告》,2021年GPU占据中国AI芯片约89%的份额。 算法:人工智能“发动机”,深度学习是主流方向。2006年深度学习算法的提出使AI进入新发展阶段,其通过卷积的方式,取代了机器学习中特征提取环节。我们认为,近年AI应用的繁荣来源于AI算法持续突破创新,而且是在大数据、大算力的支持下发挥出较大的威力。深度学习典型算法包括卷积神经网络(CNN)、递归神经网络(RNN)、前馈神经网络(FNN)、生成对抗网络(GAN)等。2017年谷歌提出Transformer算法,此后Transformer广泛应于自然语言处理,并逐步在计算机视觉等领域应用,OpenAI最近发布的ChatGPT也是以此为基础构建。 1962年:Rosenblatt出版《神经动力学原理》,及其1957年设计的模拟计算器,被视作深度神经网络模型的算法原型。 1969年:Minsky与Papert出版《感知器》,指出人造神经元的运算极限严重受限于计算机的算力不足,造成神经网络领域在1970年代面临寒冬。 1985年:Hinton与Sejnowski发表基于玻尔兹曼机的“多层神经网络”。 1986年:Rumelhart和Hinton发表“BP反向传播算法”。 1989年:Mead出版“Analog VLSI and Neural Systems”,开创基于仿生芯片的神经形态工程领域。 2006年:Hinton提出受限玻尔兹曼机模型与深度信念网络成功训练多层神经网络,解决反向传播算法局部最佳解的问题,并把多层类神经网络称作“深度学习”。 2012年:Krizhevsky与Hinton的团队在ImageNet大赛中,将图像识别错误率降到18%,并在NIPS会议上发表图像识别论文“ImageNet Classification with Deep Convolutional Neural Networks”。 1993年:Yann LeCun的团队使用DSP在一台486电脑上实现深度学习算法,其作为推理芯片,已可辨识手写的数字。 1994年:Michael Gschwind等人使用FPGAs实现 神经网络的算法应用。 2009年:Rajat Raina和吴恩达发表利用GPU完成深度学习训练的论文“ Large-scale Deep Unsupervised Learning using Graphic Processors”。 2014年:陈天石博士的研究团队,从这年开始发表以DianNao为名的系列论文,开启人工智能芯片(ASIC)的研究领域。 2015年:Jason Cong在2015年的FPGA大会上,发表一篇论文“ Optimizing FPGA based Accelerator Design for Deep Convolutional Neural Networks”,使得FPGAs迅速大火。 2016年:Google发表为TensorFlow框架设计的TPU芯片。 人工智能按产业链来划分,可分为基础层、技术层和应用层三大层面。 基础层:侧重基础支撑平台的搭建,包含传感器、AI芯片、数据服务和计算平台; 技术层:侧重核心技术的研发,主要包括算法模型、基础框架、通用技术; 应用层:注重产业应用发展主要包含行业解决方案服务、硬件产品和软件产品。 基础层提供数据资源、硬件设施以及计算力平台等一系列基本支持。具体来看,基础层包括人工智能芯片、传感器、大数据及云计算等,其中大数据与智能传感器的主要任务是数据采集,AI芯片与云计算则负责数据分析与运算,技术门槛较高,生态搭建已基本成型。目前,浪潮、戴尔、HPE分列全球人工智能基础设施市场份额前三,其中浪潮以16.4%的市场占有率成为全球人工智能基础设施的龙头玩家。 通用计算芯片CPU、GPU全球市场基本被Intel、Nvidia等美国芯片厂商垄断,技术与专利壁垒较高,卡脖子现象严重。华为麒麟、巴龙、昇腾及鲲鹏四大芯片有望突破此壁垒。未来几年,全球各大芯片企业、互联网巨头、初创企业都将成为该市场的主要玩家。计算力指数国家排名中美国列国家计算力指数排名第一,坐拥全球最多超大规模数据中心,这是美国算力的基础保障。中国列第二,AI算力领跑全球。日本、德国、英国分别位列第三至第五名。计算平台方面,全球市场被亚马逊、谷歌、阿里、腾讯、华为等公司基本垄断,但小公司的计算平台凭借价格优势仍有生存空间。 技术层是AI产业发展的核心,包括通用技术、AI技术框架以及算法模型等。这一层级依托于海量数据的挖掘处理与机器学习建模,来进行各种应用技术的开发,从而解决实践中的具体类别问题。计算机视觉、自然语言处理、语音识别、机器学习、深度学习、知识图谱为这一层级的代表性技术。优势企业如谷歌、亚马逊、Facebook加快部署机器学习、深度学习底层平台,建立产业事实标准。 3.产业链下游2.按模型分类

3.按实现阶段

(四)人工智能行业发展历程

1.神经网络发展历程

2.人工智能芯片发展历程

(五)人工智能产业链分析

1.产业链上游

2.产业链中游

应用层是人工智能技术在各不同场景下的商业化应用。人工智能已在金融、教育、交通、医疗、家居、营销等多垂直领域取得较大发展;与此同时,智能终端、模型预测控制、推荐系统、定位与地图构建等服务层面及自动驾驶汽车、无人机、智能机器人、智能语音助手等人工智能产品发展迅速。受人工智能技术应用的链条长、短期获益难度大等因素影响,一些早期的技术型企业也纷纷将重心转移到等垂直领域的软硬件解决方案当中。众多人工智能各类企业“从谋求单点技术的极致,向场景化综合生态发展”,这无疑推进了AI技术与商业应用场景的落地与融合。国外应用企业以苹果、IBM等为代表,而中国企业在应用层发展最为活跃,除华为、小米、阿里巴巴等大型企业外,众多中小型企业也纷纷加入应用层的竞争行列当中。

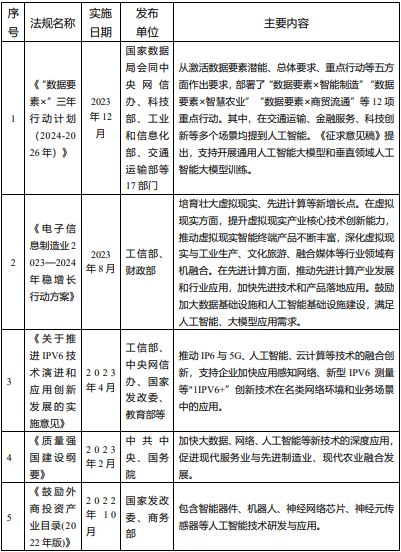

(一)行业政策分析

近年来,中国人工智能行业受到各级政府的高度重视和国家产业政策的重点支持,国家陆续出台了多项政策,鼓励人工智能行业发展与创新,《关于支持建设新一代人工智能示范应用场景的通知》《关于加快场景创新以人工智能高水平应用促进经济高质量发展的指导意见》《新型数据中心发展三年行动计划(2021-2023年)》等产业政策为我国人工智能产业发展提供了长期保障。

在2024两会政府工作报告中,更是首提“人工智能+”概念,报告提出,深化大数据、人工智能等研发应用,开展“人工智能+”行动,打造具有国际竞争力的数字产业集群。

截止2023年国家层面有关人工智能行业的政策重点内容见下表:

随着AI算力行业国家政策引导力度加强,北京、浙江、河南、贵州、云南、四川、广东、上海、山东、陕西等省份也纷纷发布相关政策规划,央地协同推动AI算力发展。

(二)市场规模

全球人工智能产业规模快速增长,软件占比提升。随着数据量的增长及相关复杂性不断增加,传统软件无法处理、分析及提取其中有用的信息,产生人工智能技术需求。根据沙利文的报告,2020年全球人工智能技术支出(包括硬件、软件、服务)为687亿美元,预计2025年达到2212亿美元,年复合增速达到26.3%。其中人工智能软件支出占比将提高,预计2025年全球人工智能软件市场规模将达到1218亿美元,占总支出比例达到55.1%,2020-2025年复合增速达到31.9%。

人工智能支出已经成为支持企业数字化转型支出的主力之一。根据IDC数据,全球范围内,企业在包括硬件、软件和服务在内的人工智能(AI)市场的技术投资增速,将显著高于数字化转型(DX)支出和GDP增速。

中国是全球人工智能第二大市场,预计增速有望全球第一。根据沙利文的报告,2020年中国人工智能市场规模为295亿元,预计2025年达到1671亿元,年复合增速为41.5%,其中软件市场规模占比将由2020年的9%提升至2025年的24.1%。

大模型方面,根据大模型之家、钛媒体数据,预计2023年全球大模型市场规模达到210亿美元,同比增长94.4%。预计到2028年全球大模型市场规模将达到1095亿美元,2022~2028年复合增长率约为47.12%,根据IDC预测,全球生成式AI计算市场规模将从2022年的8.2亿美元增长至2026