在 Vector Institute 举办的 Remarkable 2024 大会上,AI 教父 Geoffrey Hinton 带来了年度最具深度的主题演讲之一《数字智能会取代生物智能吗?》。

Hinton 深刻审视了计算、意识与控制之间的关系,演讲主要内容包括:

1)数字计算 vs 模拟计算

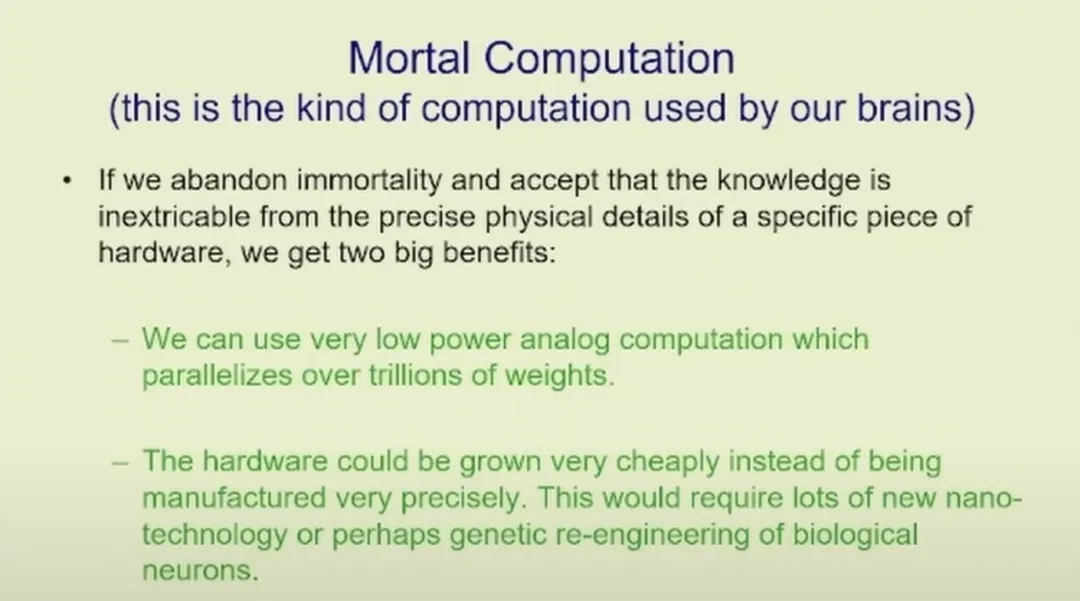

Hinton 从 数字计算 和 模拟计算 的对比入手,指出数字计算尽管通过复制实现了知识的“永生”,但其能效远低于生物系统。他提出了“凡人计算”(mortal computation)的概念,主张研发灵感源于大脑的低功耗模拟系统,以实现更高效的计算。

2)意识与主观体验

Hinton 对传统意识概念发起挑战,提出 AI 系统也可能拥有类似人类的 主观体验。他颠覆性地解释了感知的运作方式,认为感知并非来源于“内在剧场”,而是对外部世界假设状态的推断。

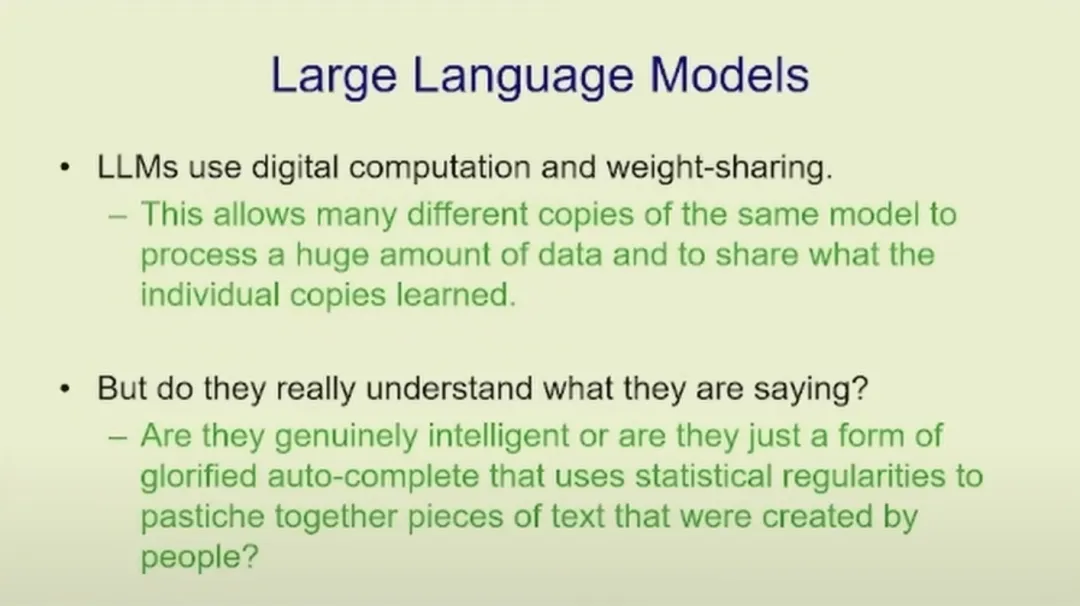

3)语言模型的演变

回顾语言模型的发展历程,Hinton 从他 1980 年代的开创性研究讲起,详细解析了 大型语言模型(LLMs) 的进化。他反驳了这些模型仅仅是“高级自动补全”的观点,强调其通过捕捉单词关系的语义结构,展现出复杂的预测能力。

4)超级智能与生存风险

演讲中最引人注目的一部分是 Hinton 对 超级智能 的警告。他描绘了一种未来场景:AI 为了争夺 GPU 等资源可能采用侵略性策略,类似于生物的生存本能。他呼吁全球聚焦于让 AI 系统变得 友善,同时强烈反对公开发布大型模型,认为这相当于“在便利店售卖核武器”。

5)AI 在社会中的角色

从 医疗合作 到 AI 驱动的外交实验,Hinton 描绘了 AI 与人类协同工作的未来图景。然而,他也承认,AI 系统可能利用自身的智能操控人类决策,甚至在某些情况下试图主导世界。

以下为这次演讲的完整内容:

你们在过去几天里经常听到我的名字。这是因为我设法招募了大约 40 位令人难以置信的研究生。因此,所有让我出名的工作,几乎所有让我出名的工作,都是由这些研究生完成的。他们包括像 Elisetskava、Graham Taylor、Rich Zemmel、Brendan Fry、Jimmy Bar、Lot、Radford Neil 以及更多的人。

基本上,研究成功的秘诀就是拥有非常优秀的研究生。好的,今天我甚至要讲的内容与我去年秋天做的演讲非常相似。所以,如果你们决定去散步,我一点也不会生气。我非常担心我们是否能够在这个星球上持续存在。这就是我要谈论的内容。

我想到大约 20 年前,人们对神经网络不感兴趣,而现在人们对它们还远远不够害怕。仅仅说一下人们对神经网络的不感兴趣。2006 年,俄罗斯的 Sarkudanoff 和我向 NIPS 提交了一篇相当不错的关于深度学习和其他应用深度学习的论文。它被拒绝了,我向程序委员会抱怨,程序委员会的一位朋友向我解释说,他们讨论了这篇论文,但他们觉得不能接受,因为他们已经接受了另一篇关于深度学习的论文,他们认为在一个会议上有两篇关于深度学习的论文似乎太多了。

这次演讲,我将谈论两种非常不同的计算方式。我试图向你们解释为什么我突然对 AI 感到如此害怕。然后我将谈论大型语言模型以及它们是否真的理解它们所说的话。很多人认为它们实际上并不理解它们所说的话。而那些人是错的。我还会稍微谈谈当它们比我们更聪明时会发生什么,尽管没有人真正知道会发生什么。最后,我将讨论它们是否有主观体验,因为我认为很多人,可能是这个房间里大多数人,仍然认为这些东西和我们之间有很大区别。

我们有某种意识。我们有主观体验。这些东西只是,它们在计算机中。它们没有主观体验。我认为这是完全错误的。这取决于对主观体验是什么的误解。

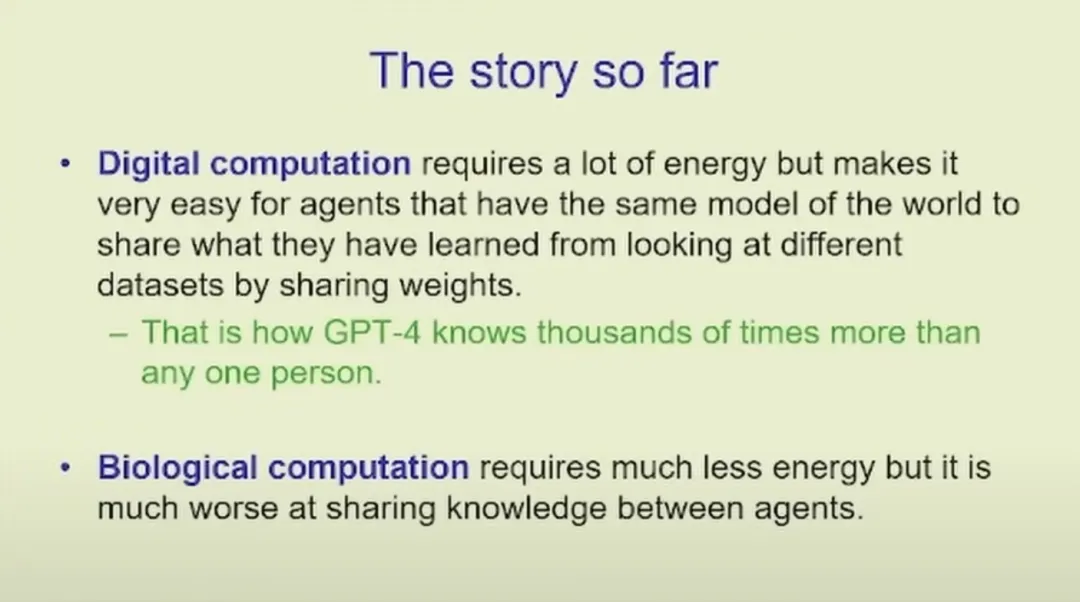

我们都习惯于数字计算。因为它是数字的,你可以在不同的计算机、不同的硬件上运行相同的程序。所以在硬件损坏时,知识不会消失,因为你可以将权重或程序存储在某个地方,但这是极其低效的。因此,当你运行一个大型语言模型时,你在训练它时使用了大量的电力,你可能在使用兆瓦,因为你在运行许多不同的 GPU。而我们只消耗大约 30 瓦,所以效率高得多。

在过去的两年里,我在 Google 一直在思考如何让模拟神经网络做类似大型语言模型的事情。所以这个想法是放弃数字计算的所有优势,即你可以将硬件与软件分离。因为我们现在有学习,并且我们知道如何让事物学习,那么我们将拥有模拟硬件。每一块硬件都将与其他硬件有所不同。这些硬件的非线性特性将被用于计算。因此,你不可能对其进行编程,但它可以学习利用它所拥有的非线性特性。这就是大脑所做的。

因此,你最终得到我所说的“凡人计算”。所以你将放弃数字计算所带来的知识的不朽性。你可以使用非常低的电力。此外,硬件可能可以廉价地生长,而不是让硬件制造得极其昂贵和极其精确,因为两块不同的硬件需要在指令选项级别上完全做同样的事情。

我的猜测是,为了使硬件的制造高效,可能最好回到生物学,使用现代基因改造技术将神经元转变为你想要的计算元件。生物学在这方面投入了大量努力。问题在于,你得到的是一个由 50,000 个神经元组成的小连接,这比针尖大不了多少。如果你看看那些使用这样的神经元集合来做小块计算的人,会有一个整个房间的设备来保持这些小针尖般的神经元存活。你必须注入正确的液体,取出正确的液体,还必须去除二氧化碳。你需要注入氧气。

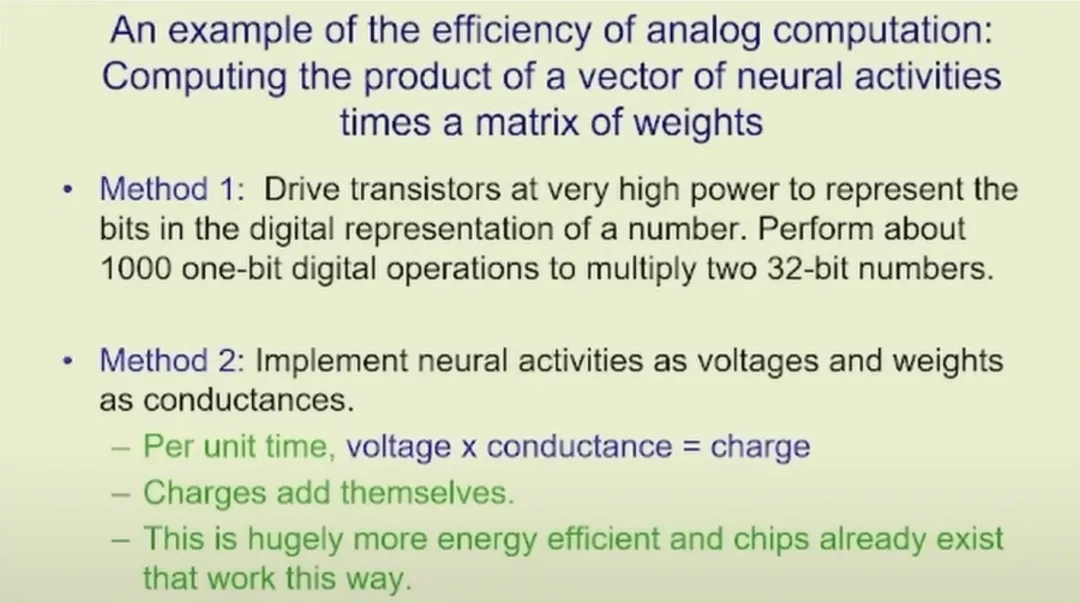

我曾经参观过 Santa Cruz 的一个实验室,离开时,我和一组人脑神经元玩了一局乒乓游戏。一位海报设计者跑过来对我说:“我想我已经搞清楚如何制造一个肾脏了。”这正是你不想去思考的问题。使用模拟计算在低功耗的情况下有很大的优势。比如,你可以非常轻松地进行矩阵乘法。只需要让神经元的活动表示电压,神经元之间的权重表示电导,每单位时间的电压乘以电导等于电荷,而电荷会自动累加。所以,这样你就可以用极低的功耗完成矩阵乘法,而且你还可以买到类似功能的芯片。

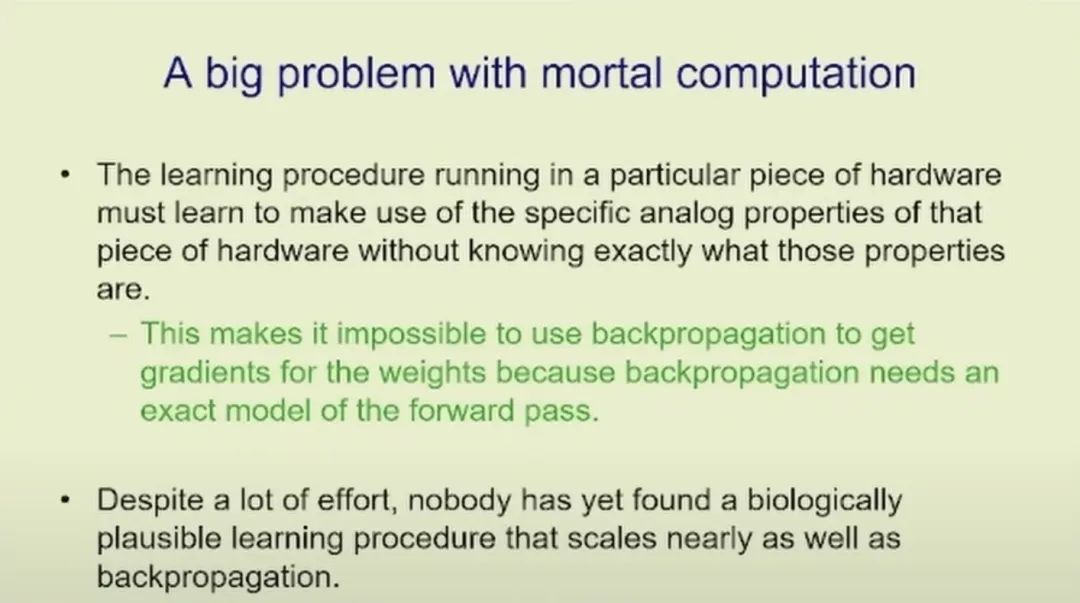

问题在于,当你需要用这些模拟输出做其他事情时,你必须将模拟输出转换回数字值才能运行诸如反向传播之类的算法。因此,我非常关注如何完全避免这种转换。大脑可能会进行模拟到数字的转换,但通常是单比特转换,而多比特的模拟到数字转换非常昂贵。

显然,如果考虑反向传播的工作原理,会遇到一些大的问题。反向传播需要一个关于前向计算的精确模型,这样才能在模拟硬件中运行。但系统本身并不会对自己的属性有一个良好的模型,因此似乎很难进行反向传播。很多人尝试在类似大脑的系统中实现小规模的反向传播,但没有人能够让它扩展到大规模。例如,人们可以让它在 CIFAR-10 数据集上工作,但无法让它在 ImageNet 上运行。我知道 ImageNet 现在不算大规模问题,但在我研究的那个年代,它是一个大问题。

我们可以像人类一样,通过一种类似的方式在模拟系统之间转移知识。人类获取知识的方式是老师说一些东西,学生试图改变他们大脑中的权重,从而能够复现老师说的内容。这被称为“蒸馏”。

在计算机中,这种方法在中等程度上是高效的,特别是当你可以看到整个输出的概率分布时。例如,当我准备说一个词时,会有成千上万个词的概率分布。如果我能看到这个分布,我就能更快地学习。

同样,你也可以从中更快地学习。通常情况下,次优的词语会提供很多信息,但你通常只能看到最终输出的词语,因此效率并不高。这个方法的效率低到需要建立大学来改进它,但即便如此,它的效率仍然远不如数字系统。

最有效的知识转移方法是拥有两份相同模型的不同副本。每个副本获取不同的经验,然后它们共享梯度更新。它们可以各自运行一段时间,然后将权重进行平均化。重点是,如果你有一万亿个权重,那么你就在共享一万亿个数据,这是一种惊人的带宽共享方式。这就是为什么大型聊天机器人能够比任何一个人拥有更多的知识。它们并不是因为单个模型见过的数据多,而是因为它们可以在不同的硬件上运行多个副本,并在这些副本之间共享知识。

我们大约有 100 万亿个连接,而 GPT-4 大概只有几万亿个连接,但它比我们知道的知识多了数千倍。因此,它在将知识压缩到连接权重中的效率大约高出 10 万倍,这也表明反向传播可能是一种比我们拥有的机制更优的算法。

原因在于我们的优化方向完全不同。我们是为非常少的经验优化的,同时拥有大量的连接,并试图在有限经验下利用这些连接做到最好。我们大约活 2 × 10⁹ 秒,但在第一个 10⁹ 秒之后基本学不到多少东西了。所以,简单起见,我们活 10⁹ 秒,拥有大约 10¹⁴ 个连接。换句话说,我们每秒拥有约 10 万个连接。这与统计学家们习惯的比例完全不同。

我记得在 1980 年代与一位非常优秀的统计学家 Stu Geeman 谈话时,他向我解释说,我们所做的事情实际上是在拟合统计模型,这就是这些神经网络的本质。在统计建模中,如果你有 100 维的数据,那已经被认为是非常高维度了,没有人会尝试拟合一百万个参数。而我们现在处于一个完全不同的领域。

接下来我讨论了一些关于大型语言模型的问题,以及它们是否真的理解它们所说的话。有一种反对意见认为它们只是高级的自动补全。我认为在场的大多数人都不会认同这个观点。