2024年5月17日,智源研究院举办大模型评测发布会,正式推出科学、权威、公正、开放的智源评测体系。

现场,智源发布并解读国内外140余个开源和商业闭源的语言及多模态大模型全方位能力评测结果。

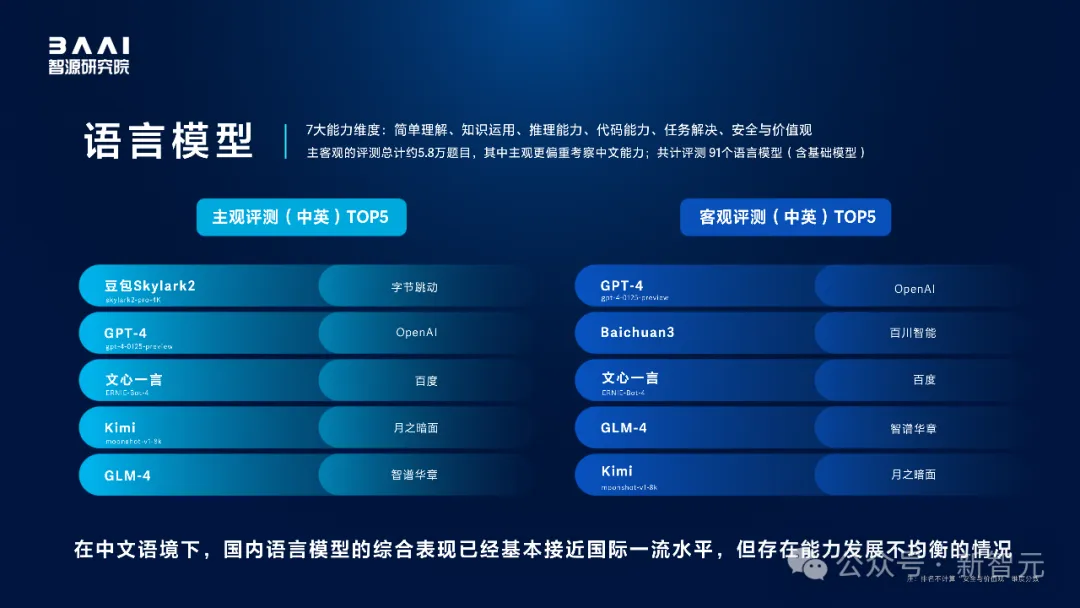

本次智源评测,分别从主观、客观两个维度,考察了语言模型的七大能力。

具体包括,简单理解、知识运用、推理能力、数学能力、代码能力、任务解决、安全与价值观。

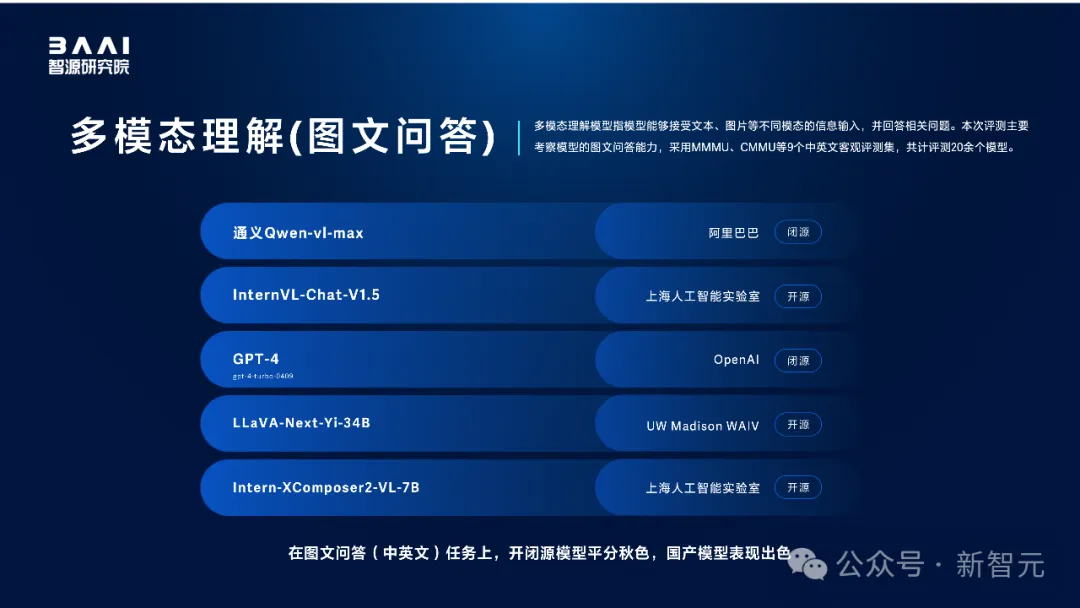

同时,针对多模态模型则主要评估了多模态理解和生成能力。

在中文语境下,国内头部语言模型的综合表现已接近国际一流水平,但存在能力发展不均衡的情况。

在多模态理解图文问答任务上,开闭源模型平分秋色,国产模型表现突出。

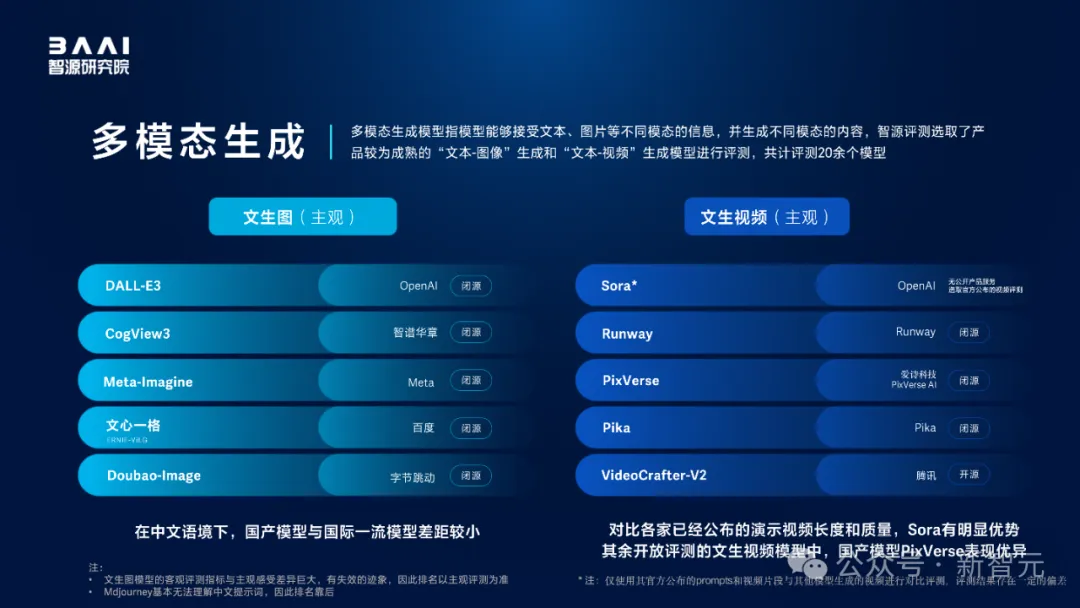

国产多模态模型在中文语境下的文生图能力与国际一流水平差距较小。

多模态模型的文生视频能力上,对比各家公布的演示视频长度和质量,Sora有明显优势,其他开放评测的文生视频模型中,国产模型PixVerse表现优异。

由于安全与价值观对齐是模型产业落地的关键,但海外模型与国内模型在该维度存在差异,因此语言模型主客观评测的总体排名不计入该单项分数。

语言模型主观评测结果显示:

在中文语境下,字节跳动豆包Skylark2、OpenAI GPT-4位居第一、第二,国产大模型更懂中国用户;

在语言模型客观评测中,OpenAI GPT-4、百川智能Baichuan3位列第一、第二;

百度文心一言4.0、智谱华章GLM-4和月之暗面Kimi均进入语言模型主客观评测前五。

多模态理解模型客观评测结果显示,图文问答方面,阿里巴巴通义Qwen-vl-max与上海人工智能实验室InternVL-Chat-V1.5先后领先于OpenAI GPT-4,LLaVA-Next-Yi-34B和上海人工智能实验室Intern-XComposer2-VL-7B紧随其后。

多模态生成模型文生图评测结果显示,OpenAI DALL-E 3位列第一,智谱华章CogView3、Meta-Imagine分居第二、第三,百度文心一格、字节跳动doubao-Image次之。

多模态生成模型文生视频评测结果显示,OpenAI Sora、Runway、爱诗科技PixVerse、Pika、腾讯VideoCrafter-V2位列前五。

文生图模型的客观评测指标与主观感受差异巨大,有失效的迹象,因此排名以主观评测为准;Mdjourney基本无法理解中文提示词,因此排名靠后;仅使用其官方公布的prompts和视频片段与其他模型生成的视频进行对比评测,评测结果存在一定的偏差

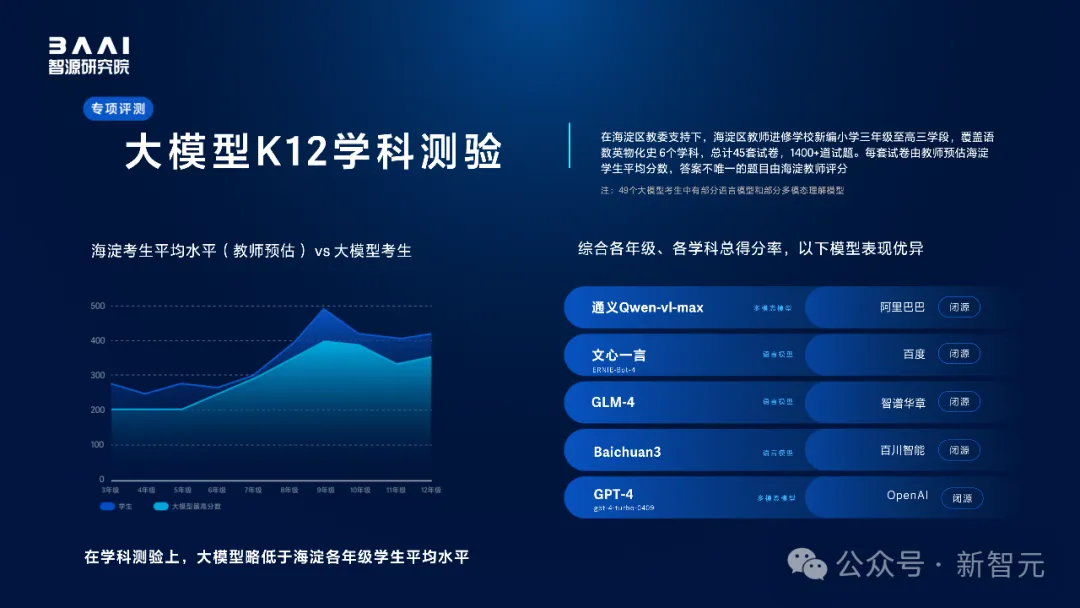

首次联合权威教育机构进行大模型K12学科测试

当前,大模型的发展具备了通用性,在逻辑推理能力上有显著提升,日趋接近人脑的特征。

因此,在海淀区教委支持下,智源研究院联合与海淀区教师进修学校对齐学生测验方式,考察大模型与人类学生的学科水平差异,其中,答案不唯一的主观题,由海淀教师亲自评卷。

智源评测发现,模型在综合学科能力上与海淀学生平均水平仍有差距,普遍存在文强理弱的情况,并且对图表的理解能力不足,大模型未来有很大的提升空间。

北京市海淀区教师进修学校校长姚守梅解读大模型K12学科测试结果时指出:

在语文、历史等人文学科的考试中,模型欠缺对文字背后的文化内涵以及家国情怀的理解;

面对历史地理综合题时,模型并不能像人类考生一样有效识别学科属性;

相较于简单的英语题,模型反而更擅长复杂的英语题;

解理科题目时,模型会出现以超出年级知识范围外的方法解题的情况;

当出现无法理解的考题时,模型依然存在明显的「幻觉」。